Webサイト初心者・個人ブロガーのための robots.txt 完全ガイド〜役割・効果・よくある誤解を解説!〜

2026.01.23

2026.01.23

Webサイト初心者・個人ブロガーのための robots.txt 完全ガイドで役割や効果,よくある誤解を解説!

Webサイトやブログを運営していると、「robots.txt(ロボッツテキスト)」という言葉を一度は目にしたことがあるのではないでしょうか。

一方で、「何のためのファイルなのかよく分からない」「設定を間違えると怖そう」「そもそも初心者が触る必要はあるのか」と感じている方も多いと思います。

本記事では、Webサイト初心者や個人ブロガーの方を主な対象として、robots.txtの役割・仕組み・効果・注意点を、できるだけ専門用語を噛み砕きながら丁寧に解説します。

難しいテクニックを覚えることよりも、「まず正しく理解すること」を重視していますので、これからブログやWebサイトを育てていきたい方はぜひ参考にしてください。

robots.txtとは何か?まずは役割を正しく理解しましょう

robots.txtとは、検索エンジンのクローラー(巡回ロボット)に対して「どのページを見てよいか/見なくてよいか」を伝えるための指示書です。

検索エンジンは、クローラーと呼ばれる自動プログラムを使って、世界中のWebページを巡回し、情報を収集しています。

robots.txtは、そのクローラーに対して、

- このページは見ていいです

- このフォルダは見ないでください

といったお願い(ルール)を伝えるファイルです。

重要なのは、robots.txtは「命令」ではなく「指示・ガイドライン」に近い存在だという点です。

一般的な検索エンジンはこの指示を尊重しますが、完全なアクセス制限やセキュリティ対策ではありません。

robots.txtでできること・できないこと

初心者の方が混乱しやすいポイントとして、「robots.txtで何ができて、何ができないのか」を整理しておくことがとても大切です。

robots.txtでできること

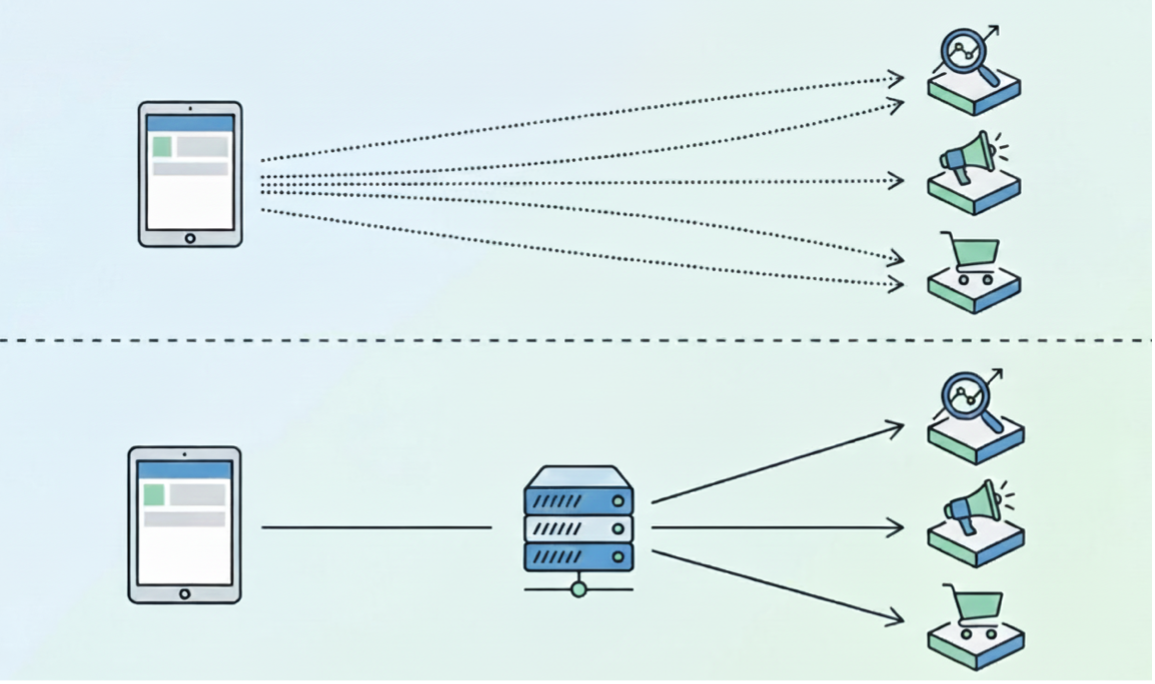

- 検索エンジンのクローラーに対して、クロール(巡回)を控えてほしい場所を伝える

- 管理画面やテストページなど、検索結果に出す必要のないURLへのクロールを抑制する

- サイト全体のクロール効率を整理する

robots.txtでできないこと

- ページを完全に非公開にする(アクセス制限はできません)

- 検索結果から必ず削除する(インデックス削除の保証はありません)

- セキュリティ対策として情報を守る

特に初心者の方が誤解しやすいのが、「robots.txtに書けば検索結果に出なくなる」という考え方です。

実際には、インデックス制御(検索結果に出す/出さない)は別の方法で行う必要があります。

なぜrobots.txtが存在するのか?初心者にも関係がある理由

「小規模なブログなら、robots.txtは不要なのでは?」と思う方もいるかもしれません。

しかし、最低限の理解はとても重要です。

理由は以下の通りです。

- 誤って重要なページをブロックしてしまうと、検索結果に表示されなくなる可能性がある

- WordPressなどのCMSでは、自動生成されたURLが多く存在する

- プラグインやテーマの影響で、意図しないクロールが発生することがある

特に、テンプレートや他人の設定例をそのままコピーしてrobots.txtを設置するのは危険です。

意味を理解せずに設定すると、SEOに悪影響を与えることもあります。

robots.txtの基本的な書き方(初心者向け)

robots.txtは、Webサイトの一番上の階層(例:https://example.com/robots.txt)に置くテキストファイルです。

初心者の方がまず知っておきたいのは、以下の2つの項目です。

User-agent

どのクローラーに対する指示かを指定します。

User-agent: *

「*」は「すべてのクローラー」という意味です。

Disallow

クロールしてほしくないURLやフォルダを指定します。

Disallow: /test/ これは、「/test/以下は見ないでください」という意味になります。

初心者がやりがちな robots.txt のよくある間違い

1. robots.txtでアクセス制限できると思っている

robots.txtは、一般ユーザーのアクセスを制限するものではありません。

URLを知っていれば、誰でもページを見ることができます。

2. インデックス削除目的で使ってしまう

検索結果に表示させたくない場合は、noindex設定など別の方法が必要です。

robots.txtでブロックすると、かえって検索エンジンが中身を確認できなくなるケースもあります。

3. CSSやJavaScriptをブロックしてしまう

見た目や動作に必要なファイルをブロックすると、検索エンジンがページを正しく評価できなくなります。

初心者の方は、基本的にCSSやJSはブロックしない方が安全です。

個人ブロガーがrobots.txtを触るべきタイミング

以下のような場合を除き、最初から細かく設定する必要はありません。

- 管理画面や下書きURLが検索結果に出てしまっている

- テスト用ページが大量に生成されている

- 明確にクロールを抑制したいフォルダがある

それ以外の場合は、「何もしない」ことが最適な選択になるケースも多いです。

robots.txtとSEOの正しい付き合い方

robots.txtは、SEOを直接的に強化する魔法のファイルではありません。

むしろ、SEOの土台を壊さないための調整役と考えると分かりやすいです。

初心者・個人ブロガーの方は、

- 役割を理解する

- むやみに触らない

- 変更する場合は必ず意味を確認する

この3点を守るだけでも、大きな失敗は防げます。

まとめ:まずは「理解する」ことが最大のSEO対策です

robots.txtは、一見すると難しそうですが、役割はとてもシンプルです。

「検索エンジンに対する案内板」だと考えてください。

初心者のうちは、完璧な設定を目指す必要はありません。

それよりも、

- 何のために存在するのか

- 何ができて、何ができないのか

を理解することが、長く安定したWebサイト運営につながります。

この記事が、robots.txtに対する不安を少しでも減らし、安心してサイト運営を続ける手助けになれば幸いです。

TOP

TOP

前の記事

前の記事